GPT Academic

为GPT/GLM等LLM大语言模型提供实用化交互接口,特别优化论文阅读/润色/写作体验,模块化设计,支持自定义快捷按钮&函数插件,支持Python和C++等项目剖析&自译解功能,PDF/LaTex论文翻译&总结功能,支持并行问询多种LLM模型,支持chatglm3等本地模型。接入通义千问, deepseekcoder, 讯飞星火, 文心一言, llama2, rwkv, claude2, moss等。

- 官方主页:GPT Academic GitHub Repository

- 部署教程:GPT Academic GitHub Repository#installation

- 使用指南:GPT Academic GitHub Repository-wiki-项目配置说明

效果演示

特性

| 功能(⭐= 近期新增功能) | 描述 |

|---|---|

| ⭐接入新模型 | 百度千帆与文心一言, 通义千问Qwen,上海AI-Lab书生,讯飞星火,LLaMa2,智谱GLM4,DALLE3, DeepseekCoder |

| ⭐支持mermaid图像渲染 | 支持让GPT生成流程图、状态转移图、甘特图、饼状图、GitGraph等等(3.7版本) |

| ⭐Arxiv论文精细翻译 (Docker) | [插件] 一键以超高质量翻译arxiv论文,目前最好的论文翻译工具 |

| ⭐实时语音对话输入 | [插件] 异步监听音频,自动断句,自动寻找回答时机 |

| ⭐AutoGen多智能体插件 | [插件] 借助微软AutoGen,探索多Agent的智能涌现可能! |

| ⭐虚空终端插件 | [插件] 能够使用自然语言直接调度本项目其他插件 |

| 润色、翻译、代码解释 | 一键润色、翻译、查找论文语法错误、解释代码 |

| 自定义快捷键 | 支持自定义快捷键 |

| 模块化设计 | 支持自定义强大的插件,插件支持热更新 |

| 程序剖析 | [插件] 一键剖析Python/C/C++/Java/Lua/...项目树 或 自我剖析 |

| 读论文、翻译论文 | [插件] 一键解读latex/pdf论文全文并生成摘要 |

| Latex全文翻译、润色 | [插件] 一键翻译或润色latex论文 |

| 批量注释生成 | [插件] 一键批量生成函数注释 |

| Markdown中英互译 | [插件] 看到上面5种语言的README了吗?就是出自他的手笔 |

| PDF论文全文翻译功能 | [插件] PDF论文提取题目&摘要+翻译全文(多线程) |

| Arxiv小助手 | [插件] 输入arxiv文章url即可一键翻译摘要+下载PDF |

| Latex论文一键校对 | [插件] 仿Grammarly对Latex文章进行语法、拼写纠错+输出对照PDF |

| 谷歌学术统合小助手 | [插件] 给定任意谷歌学术搜索页面URL,让gpt帮你写relatedworks |

| 互联网信息聚合+GPT | [插件] 一键让GPT从互联网获取信息回答问题,让信息永不过时 |

| 公式/图片/表格显示 | 可以同时显示公式的tex形式和渲染形式,支持公式、代码高亮 |

| 启动暗色主题 | 在浏览器url后面添加/?__theme=dark可以切换dark主题 |

| 多LLM模型支持 | 同时被GPT3.5、GPT4、清华ChatGLM2、复旦MOSS伺候的感觉一定会很不错吧? |

| 更多LLM模型接入,支持huggingface部署 | 加入Newbing接口(新必应),引入清华Jittorllms支持LLaMA和盘古α |

| ⭐void-terminal pip包 | 脱离GUI,在Python中直接调用本项目的所有函数插件(开发中) |

| 更多新功能展示 (图像生成等) …… | 见官方文档结尾处 …… |

AI 模型配置方法

GPT Academic 是服务端部署,需要在部署的 config.py 文件,或者 docker-compose.yml 文件中进行修改:【第三方API‐KEY接入】

参数填写

Api Key:前往 OpenAI 官网,或者ZetaTechs API获取。

请求地址格式:

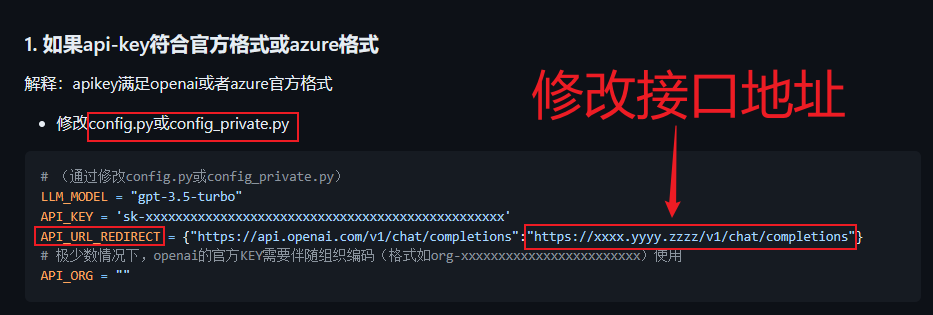

图文指引

示例

通过修改config.py或config_private.py

LLM_MODEL = "gpt-3.5-turbo"

API_KEY = 'sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx'

API_URL_REDIRECT = {"https://api.openai.com/v1/chat/completions":"https://api.zetatechs.com/v1/chat/completions"}

# 极少数情况下,openai的官方KEY需要伴随组织编码(格式如org-xxxxxxxxxxxxxxxxxxxxxxxx)使用

API_ORG = ""

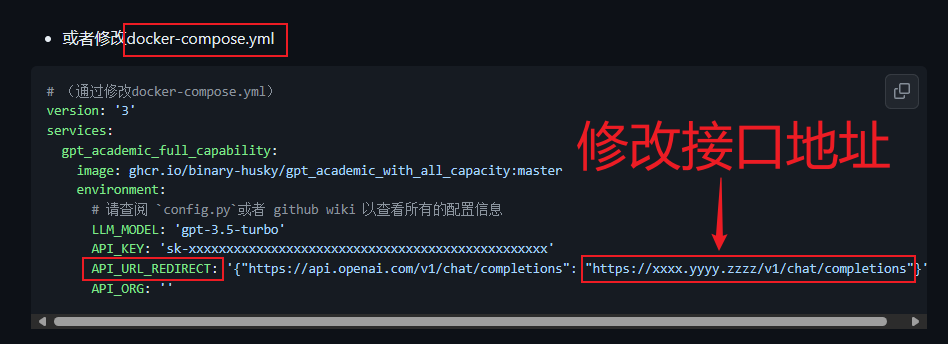

通过修改docker-compose.yml

## 「方案四」 ChatGPT + Latex

## ===================================================

version: '3'

services:

gpt_academic_with_latex:

image: ghcr.io/binary-husky/gpt_academic_with_latex:master # (Auto Built by Dockerfile: docs/GithubAction+NoLocal+Latex)

ports:

- "12303:12303"

environment:

# 请查阅 `config.py` 以查看所有的配置信息

API_KEY: ' sk-toiT32BceQq5ei4F01B29eD7562045E1A4855eF5A5E8A225 '

USE_PROXY: ' False '

proxies: ' { "http": "socks5h://localhost:10880", "https": "socks5h://localhost:10880", } '

LLM_MODEL: ' gpt-3.5-turbo '

API_URL_REDIRECT: '{"https://api.openai.com/v1/chat/completions": "https://api.zetatechs.com/v1/chat/completions"}'

AVAIL_LLM_MODELS: ' ["gpt-3.5-turbo", "gpt-4o", "one-api-claude-3-haiku-20240307", "one-api-claude-3-sonnet-20240229", "one-api-claude-3-opus-20240229", "one-api-gemini-1.5-flash-latest", "one-api-gemini-1.5-pro-latest"] '

LOCAL_MODEL_DEVICE: ' cuda '

DEFAULT_WORKER_NUM: ' 10 '

WEB_PORT: ' 12303 '

# THEME: ' Chuanhu-Small-and-Beautiful '

# DEFAULT_WORKER_NUM: ' 10 '

# AUTHENTICATION: ' [("username1", "xxxxxxxxxxxxxxxxx")] '

# 「WEB_PORT暴露方法1: 适用于Linux」与宿主的网络融合

networks:

- default

# 启动命令

command: >

bash -c "python3 -u main.py"